You are looking for information, articles, knowledge about the topic nail salons open on sunday near me 쿠다 on Google, you do not find the information you need! Here are the best content compiled and compiled by the https://toplist.maxfit.vn team, along with other related topics such as: 쿠다 쿠다 프로그래밍, 쿠다 파이썬, CUDA wiki, 라데온 쿠다코어, cuda 지원 그래픽카드, 쿠다 설치, 지포스 쿠다, 쿠다코어 갯수

CUDA(“Compute Unified Device Architecture”, 쿠다)는 그래픽 처리 장치(GPU)에서 수행하는 (병렬 처리) 알고리즘을 C 프로그래밍 언어를 비롯한 산업 표준 언어를 사용하여 작성할 수 있도록 하는 GPGPU 기술이다.

CUDA – 위키백과, 우리 모두의 백과사전

- Article author: ko.wikipedia.org

- Reviews from users: 48645

Ratings

- Top rated: 4.4

- Lowest rated: 1

- Summary of article content: Articles about CUDA – 위키백과, 우리 모두의 백과사전 Updating …

- Most searched keywords: Whether you are looking for CUDA – 위키백과, 우리 모두의 백과사전 Updating

- Table of Contents:

이점[편집]

제한[편집]

지원 GPU[편집]

언어 결합[편집]

예제[편집]

같이 보기[편집]

각주 및 참고 문헌[편집]

외부 링크[편집]

CUDA (쿠다) 란, 왜 사용하는 것인가.

- Article author: hiuaa.tistory.com

- Reviews from users: 28696

Ratings

- Top rated: 4.1

- Lowest rated: 1

- Summary of article content: Articles about CUDA (쿠다) 란, 왜 사용하는 것인가. CUDA (Computed Unified Device Architecture) 는 NVIDIA 사에서 개발한 GPU (Graphic Processing Unit)개발 툴이다. (설치방법 링크). …

- Most searched keywords: Whether you are looking for CUDA (쿠다) 란, 왜 사용하는 것인가. CUDA (Computed Unified Device Architecture) 는 NVIDIA 사에서 개발한 GPU (Graphic Processing Unit)개발 툴이다. (설치방법 링크). CUDA (Computed Unified Device Architecture) 는 NVIDIA 사에서 개발한 GPU (Graphic Processing Unit)개발 툴이다. (설치방법 링크) CUDA C 라는 언어를 사용하고 C++/C 등에 넣어 사용할 수 있다. (이 블로그에..내꿈은자동화

- Table of Contents:

CUDA (쿠다) 란, 왜 사용하는 것인가. :: Kaen’s Ritus

- Article author: kaen2891.tistory.com

- Reviews from users: 26426

Ratings

- Top rated: 3.9

- Lowest rated: 1

- Summary of article content: Articles about CUDA (쿠다) 란, 왜 사용하는 것인가. :: Kaen’s Ritus CUDA (Computed Unified Device Architecture)는 NVIDIA에서 개발한 GPU 개발 툴이다. 사실 CUDA는 c, c++기반으로 짜여진 완전 기초적 H/W 접근을 … …

- Most searched keywords: Whether you are looking for CUDA (쿠다) 란, 왜 사용하는 것인가. :: Kaen’s Ritus CUDA (Computed Unified Device Architecture)는 NVIDIA에서 개발한 GPU 개발 툴이다. 사실 CUDA는 c, c++기반으로 짜여진 완전 기초적 H/W 접근을 … CUDA (Computed Unified Device Architecture)는 NVIDIA에서 개발한 GPU 개발 툴이다. 사실 CUDA는 c, c++기반으로 짜여진 완전 기초적 H/W 접근을 해야하는데, 많은 연구자들이 딥러닝에 사용할 수 있도록, 쉽게..Only in the agony of parting do we look into the depths of love

—

낭만은 짧고 지저분한 질척거림만 남은 첫눈처럼 유독 추운 겨울이었고 누군가 떠날 것 같았다. - Table of Contents:

CUDA (쿠다) 란 왜 사용하는 것인가

티스토리툴바

[빅데이터] 딥러닝을 위한 GPU _ 쿠다(CUDA) : 네이버 블로그

- Article author: m.blog.naver.com

- Reviews from users: 3223

Ratings

- Top rated: 4.2

- Lowest rated: 1

- Summary of article content: Articles about [빅데이터] 딥러닝을 위한 GPU _ 쿠다(CUDA) : 네이버 블로그 [빅데이터] 딥러닝을 위한 GPU _ 쿠다(CUDA) · 딥러닝이란 컴퓨터가 알고리즘을 기반으로 학습해서 사람처럼 스스로 인지, 판단하여 데이터를 분석하는 … …

- Most searched keywords: Whether you are looking for [빅데이터] 딥러닝을 위한 GPU _ 쿠다(CUDA) : 네이버 블로그 [빅데이터] 딥러닝을 위한 GPU _ 쿠다(CUDA) · 딥러닝이란 컴퓨터가 알고리즘을 기반으로 학습해서 사람처럼 스스로 인지, 판단하여 데이터를 분석하는 …

- Table of Contents:

카테고리 이동

에이콘아카데미 공식블로그

이 블로그

정보

카테고리 글

카테고리

이 블로그

정보

카테고리 글

![[빅데이터] 딥러닝을 위한 GPU _ 쿠다(CUDA) : 네이버 블로그](https://blogthumb.pstatic.net/MjAxNzA0MDZfMjI0/MDAxNDkxNDc3NzkzOTQy.zFZ9v6EfT1-yQ_FZvVTtNcaQ9lPMrNnaxTJ2RUgybHcg.Gvii6vKY16pd8PWBvfVsKOJ4KQeuy91ykxg3w5PrE2Mg.JPEG.acornedu/%B5%F6%B7%AF%B4%D7%C0%BB_%C0%A7%C7%D1_GPU___%C4%ED%B4%D9-1.jpg?type=w2)

CUDA – OpenCV

- Article author: opencv.org

- Reviews from users: 25867

Ratings

- Top rated: 4.4

- Lowest rated: 1

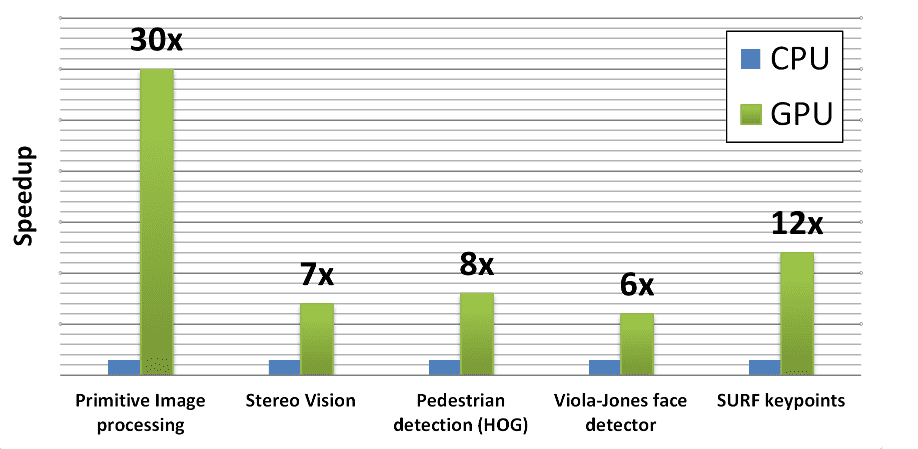

- Summary of article content: Articles about CUDA – OpenCV CUDA. Motivation. Modern GPU accelerators has become powerful and featured enough to be capable to perform general purpose computations (GPGPU) … …

- Most searched keywords: Whether you are looking for CUDA – OpenCV CUDA. Motivation. Modern GPU accelerators has become powerful and featured enough to be capable to perform general purpose computations (GPGPU) …

- Table of Contents:

쿠다미미의 고양이 8 – 나카야마 미유키 – Google Sách

- Article author: books.google.com.vn

- Reviews from users: 25496

Ratings

- Top rated: 3.1

- Lowest rated: 1

- Summary of article content: Articles about 쿠다미미의 고양이 8 – 나카야마 미유키 – Google Sách Updating …

- Most searched keywords: Whether you are looking for 쿠다미미의 고양이 8 – 나카야마 미유키 – Google Sách Updating 쿠다에게 씌어 공포의 대상이 되는 바람에 은둔형 외톨이가 된 소녀, 이이즈나 네네코는 쿠다를 제거할 단서를 찾아 진료소에서 무녀로 일하게 된다. 강해지기 위한 수행을 시작한 메메에게 반 친구들이 다가오는데…….

- Table of Contents:

Error

- Article author: prod.danawa.com

- Reviews from users: 24258

Ratings

- Top rated: 3.5

- Lowest rated: 1

- Summary of article content: Articles about Error Seagate 파이어쿠다 530 히트싱크 M.2 NVMe (4TB). 상세 스펙. 내장형SSD / M.2 (2280) / PCIe4.0x4 (64GT/s) / NVMe 1.4 / TLC(기타) / 3D낸드 / 컨트롤러: E18 / …

- Most searched keywords: Whether you are looking for Error Seagate 파이어쿠다 530 히트싱크 M.2 NVMe (4TB). 상세 스펙. 내장형SSD / M.2 (2280) / PCIe4.0x4 (64GT/s) / NVMe 1.4 / TLC(기타) / 3D낸드 / 컨트롤러: E18 /

- Table of Contents:

GitHub – JuliaGPU/CUDA.jl: CUDA programming in Julia.

- Article author: github.com

- Reviews from users: 47325

Ratings

- Top rated: 4.6

- Lowest rated: 1

- Summary of article content: Articles about GitHub – JuliaGPU/CUDA.jl: CUDA programming in Julia. The CUDA.jl package is the main programming interface for working with NVIDIA CUDA GPUs using Julia. It features a user-friendly array abstraction, … …

- Most searched keywords: Whether you are looking for GitHub – JuliaGPU/CUDA.jl: CUDA programming in Julia. The CUDA.jl package is the main programming interface for working with NVIDIA CUDA GPUs using Julia. It features a user-friendly array abstraction, … CUDA programming in Julia. Contribute to JuliaGPU/CUDA.jl development by creating an account on GitHub.

- Table of Contents:

Latest commit

Git stats

Files

READMEmd

Requirements

Quick start

Supporting and Citing

Project Status

Questions and Contributions

About

Releases

64

Contributors 110

Languages

Footer

See more articles in the same category here: https://toplist.maxfit.vn/blog/.

위키백과, 우리 모두의 백과사전

CUDA 처리 흐름의 예

1. 메인 메모리를 GPU 메모리로 복사

2. CPU가 GPU에 프로세스를 지시함

3. GPU가 각 코어에 병렬 수행

4. GPU 메모리로부터의 결과물을 메인 메모리에 복사 1. 메인 메모리를 GPU 메모리로 복사2. CPU가 GPU에 프로세스를 지시함3. GPU가 각 코어에 병렬 수행4. GPU 메모리로부터의 결과물을 메인 메모리에 복사

CUDA(“Compute Unified Device Architecture”, 쿠다)는 그래픽 처리 장치(GPU)에서 수행하는 (병렬 처리) 알고리즘을 C 프로그래밍 언어를 비롯한 산업 표준 언어를 사용하여 작성할 수 있도록 하는 GPGPU 기술이다. CUDA는 엔비디아가 개발해오고 있으며 이 아키텍처를 사용하려면 엔비디아 GPU와 특별한 스트림 처리 드라이버가 필요하다. CUDA는 G8X GPU로 구성된 지포스 8 시리즈급 이상에서 동작한다. CUDA 플랫폼은 컴퓨터 커널의 실행을 위해 GPU의 가상 명령 집합과 병렬 연산 요소들을 직접 접근할 수 있는 소프트웨어 계층이다.[1]

개발자는 패스스케일 오픈64 C 컴파일러로 컴파일 된 ‘쿠다를 위한 C’ (C언어를 엔비디아가 확장한 것)를 사용하여 GPU 상에서 실행시킬 알고리듬을 작성할 수 있다. 쿠다 구조는 일련의 계산 인터페이스를 지원하며 이에는 OpenCL, DirectX Compute가 포함된다. C 언어가 아닌 다른 프로그래밍언어에서의 개발을 위한 래퍼(Wrapper)도 있는데, 현재 파이썬, 펄, 포트란, 자바와 매트랩 등을 위한 것들이 있다. 이러한 접근성은 병렬 프로그래밍 전문가들이 GPU 리소스를 쉽게 이용할 수 있게 해주며, 이는 그래픽스 프로그래밍의 고급 기술을 요구하였던 Direct3D와 OpenGL과 같은 이전 API 솔루션들과 대비된다. 또, CUDA는 OpenACC와 OpenCL과 같은 프로그래밍 프레임워크를 지원한다.[1]

최신 드라이버는 모두 필요한 쿠다 콤포넌트를 담고 있다. 쿠다는 모든 엔비디아 GPU (G8X 시리즈 이후)를 지원하며 이 대상에는 지포스, 쿼드로, 테슬라 제품군이 포함된다. 엔비디아는 지포스 8 시리즈를 위해 개발된 프로그램들이 수정 없이 모든 미래의 엔비디아 비디오 카드에서 실행될 것이라고 선언하였다.

쿠다를 통해 개발자들은 쿠다 GPU 안 병렬 계산 요소 고유의 명령어 집합과 메모리에 접근할 수 있다. 쿠다를 사용하여 최신 엔비디아 GPU를 효과적으로 개방적으로 사용할 수 있다. 그러나 CPU와는 달리 GPU는 병렬 다수 코어 구조를 가지고 있고, 각 코어는 수천 스레드를 동시에 실행시킬 수 있다. 응용 프로그램이 수행하는 작업(계산)이 이러한 병렬처리연산에 적합할 경우, GPU를 이용함으로써 커다란 성능 향상을 기대할 수 있다.

컴퓨터 게임 업계에서는 그래픽 랜더링에 덧붙여, 그래픽 카드의 게임 물리 계산 (파편, 연기, 불, 유체 등 물리 효과)에 사용되며, 예로는 피직스와 불렛이 있다. 쿠다는 그래픽이 아닌 응용 프로그램, 즉, 계산 생물학, 암호학, 그리고 다른 분야에서 10배 또는 그 이상의 속도 혜택을 가져왔다. 이 한 예는 BOINC 분산 계산 클라이언트이다.

쿠다는 저수준 API와 고수준 API 모두를 제공한다. 최초의 CUDA SDK는 2007년 2월 15일에 공개되었으며 마이크로소프트 윈도우와 리눅스를 지원했다. OS X 지원은 2.0 버전에 추가되었다.

이점 [ 편집 ]

쿠다가 그래픽 API를 사용하는 전통적인 범용 GPU에 비해 가지는 몇가지 장점은 다음과 같다.

흩뿌린 읽기 – 코드가 메모리의 임의 위치에서 데이터를 읽을 수 있다.

공유 메모리 – 쿠다는 고속 공유 메모리 지역 (16 또는 48KB 크기) 을 드러내어 스레드 간에 나눌 수 있게 해 준다. 이는 사용자 관리 캐시로 사용될 수 있는데, 텍스처 룩업을 이용하는 경우 보다 더 빠른 대역폭이 가능해진다.

디바이스 상의 읽기, 쓰기가 호스트보다 더 빠르다.

정수와 비트 단위 연산을 충분히 지원한다. 정수 텍스처 룩업이 포함된다.

제한 [ 편집 ]

재귀호출, 함수 포인터가 없는 C 언어의 하부 집합을 확장하여 사용한다. 그러나 한개의 처리 장치가 여러개의 쪼개진 메모리 공간에 대하여 작업하여야 하는 점이 다른 C 언어 실행 환경과 다른 점이다.

텍스처 랜더링은 지원 되지 않는다.

배정도에 관해서는 IEEE 754 표준과 다르지 않다. 단정도에서는 비정규 값과 신호 NaN이 지원되지 않고, IEEE 반올림 모드 가운데서는 두가지만 지원하며, 이도 명령어에 따라서 지원되는 것으로 제어 단어(Control word)에서 지원 되는 것은 아니다.(이것이 제한점인지는 논란의 대상이 될 수 있다) 그리고 나눗셈과 제곱근의 정밀도가 단정도에 비해 조금 낮다.

CPU와 GPU 사이의 버스 대역폭과 시간 지연에서 병목이 발생할 수 있다.

스레드가 최소한 32개씩 모여서 실행되어야 최선의 성능 향상을 얻을 수 있으며, 스레드 수의 합이 수천개가 되어야 한다. 프로그램 코드에서의 분기는, 각각의 32 스레드가 같은 실행 경로를 따른다면, 성능에 큰 지장을 주지 않는다. SIMD 실행 모델은 어떠한 내재적으로 분기하는 임무에게는 심각한 제한이 된다. (예를 들어, 광선 추적 가속 자료 구조)

쿠다 기반 GPU는 엔비디아에서만 나온다.

지원 GPU [ 편집 ]

CUDA 수준의 지원 GPU 및 카드이다. 엔비디아 웹사이트도 참고할 것:

연산

능력

(버전) 마이크로-

아키텍처 GPU 지포스 쿼드로 워크스테이션, 데이터센터 기타 1.0 테슬라 G80 지포스 8800 울트라, 지포스 8800 GTX, 지포스 8800 GTS(G80) 쿼드로 FX 5600, 쿼드로 FX 4600, 쿼드로 Plex 2100 S4 테슬라 C870, 테슬라 D870, 테슬라 S870 1.1 G92, G94, G96, G98, G84, G86 지포스 GTS 250, 지포스 9800 GX2, 지포스 9800 GTX, 지포스 9800 GT, 지포스 8800 GTS(G92), 지포스 8800 GT, 지포스 9600 GT, 지포스 9500 GT, 지포스 9400 GT, 지포스 8600 GTS, 지포스 8600 GT, 지포스 8500 GT, 지포스 G110M, 지포스 9300M GS, 지포스 9200M GS, 지포스 9100M G, 지포스 8400M GT, 지포스 G105M 쿼드로 FX 4700 X2, 쿼드로 FX 3700, 쿼드로 FX 1800, 쿼드로 FX 1700, 쿼드로 FX 580, 쿼드로 FX 570, 쿼드로 FX 470, 쿼드로 FX 380, 쿼드로 FX 370, 쿼드로 FX 370 Low Profile, 쿼드로 NVS 450, 쿼드로 NVS 420, 쿼드로 NVS 290, 쿼드로 NVS 295, 쿼드로 Plex 2100 D4, 쿼드로 FX 3800M, 쿼드로 FX 3700M, 쿼드로 FX 3600M, 쿼드로 FX 2800M, 쿼드로 FX 2700M, 쿼드로 FX 1700M, 쿼드로 FX 1600M, 쿼드로 FX 770M, 쿼드로 FX 570M, 쿼드로 FX 370M, 쿼드로 FX 360M, 쿼드로 NVS 320M, 쿼드로 NVS 160M, 쿼드로 NVS 150M, 쿼드로 NVS 140M, 쿼드로 NVS 135M, 쿼드로 NVS 130M, 쿼드로 NVS 450, 쿼드로 NVS 420, 쿼드로 NVS 295 1.2 GT218, GT216, GT215 지포스 GT 340*, 지포스 GT 330*, 지포스 GT 320*, 지포스 315*, 지포스 310*, 지포스 GT 240, 지포스 GT 220, 지포스 210, 지포스 GTS 360M, 지포스 GTS 350M, 지포스 GT 335M, 지포스 GT 330M, 지포스 GT 325M, 지포스 GT 240M, 지포스 G210M, 지포스 310M, 지포스 305M 쿼드로 FX 380 Low Profile, 엔비디아 NVS 300, 쿼드로 FX 1800M, 쿼드로 FX 880M, 쿼드로 FX 380M, 엔비디아 NVS 300, NVS 5100M, NVS 3100M, NVS 2100M, ION 1.3 GT200, GT200b 지포스 GTX 295, GTX 285, GTX 280, 지포스 GTX 275, 지포스 GTX 260 쿼드로 FX 5800, 쿼드로 FX 4800, 쿼드로 FX 4800 for Mac, 쿼드로 FX 3800, 쿼드로 CX, 쿼드로 Plex 2200 D2 테슬라 C1060, 테슬라 S1070, 테슬라 M1060 2.0 페르미 GF100, GF110 지포스 GTX 590, 지포스 GTX 580, 지포스 GTX 570, 지포스 GTX 480, 지포스 GTX 470, 지포스 GTX 465, 지포스 GTX 480M 쿼드로 6000, 쿼드로 5000, 쿼드로 4000, 쿼드로 4000 for Mac, 쿼드로 Plex 7000, 쿼드로 5010M, 쿼드로 5000M 테슬라 C2075, 테슬라 C2050/C2070, 테슬라 M2050/M2070/M2075/M2090 2.1 GF104, GF106 GF108, GF114, GF116, GF117, GF119 지포스 GTX 560 Ti, 지포스 GTX 550 Ti, 지포스 GTX 460, 지포스 GTS 450, 지포스 GTS 450*, 지포스 GT 640 (GDDR3), 지포스 GT 630, 지포스 GT 620, 지포스 GT 610, 지포스 GT 520, 지포스 GT 440, 지포스 GT 440*, 지포스 GT 430, 지포스 GT 430*, 지포스 GT 420*, 지포스 GTX 675M, 지포스 GTX 670M, 지포스 GT 635M, 지포스 GT 630M, 지포스 GT 625M, 지포스 GT 720M, 지포스 GT 620M, 지포스 710M, 지포스 610M, 지포스 820M, 지포스 GTX 580M, 지포스 GTX 570M, 지포스 GTX 560M, 지포스 GT 555M, 지포스 GT 550M, 지포스 GT 540M, 지포스 GT 525M, 지포스 GT 520MX, 지포스 GT 520M, 지포스 GTX 485M, 지포스 GTX 470M, 지포스 GTX 460M, 지포스 GT 445M, 지포스 GT 435M, 지포스 GT 420M, 지포스 GT 415M, 지포스 710M, 지포스 410M 쿼드로 2000, 쿼드로 2000D, 쿼드로 600, 쿼드로 410, 쿼드로 4000M, 쿼드로 3000M, 쿼드로 2000M, 쿼드로 1000M, NVS 5400M, NVS 5200M, NVS 4200M, 엔비디아 NVS 315, 엔비디아 NVS 310 3.0 케플러 GK104, GK106, GK107 지포스 GTX 770, 지포스 GTX 760, 지포스 GT 740, 지포스 GTX 690, 지포스 GTX 680, 지포스 GTX 670, 지포스 GTX 660 Ti, 지포스 GTX 660, 지포스 GTX 650 Ti BOOST, 지포스 GTX 650 Ti, 지포스 GTX 650, 지포스 GTX 880M, 지포스 GTX 780M, 지포스 GTX 770M, 지포스 GTX 765M, 지포스 GTX 760M, 지포스 GTX 680MX, 지포스 GTX 680M, 지포스 GTX 675MX, 지포스 GTX 670MX, 지포스 GTX 660M, 지포스 GT 750M, 지포스 GT 650M, 지포스 GT 745M, 지포스 GT 645M, 지포스 GT 740M, 지포스 GT 730M, 지포스 GT 640M, 지포스 GT 640M LE, 지포스 GT 735M, 지포스 GT 730M 쿼드로 K5000, 쿼드로 K4200, 쿼드로 K4000, 쿼드로 K2000, 쿼드로 K2000D, 쿼드로 K600, 쿼드로 K420, 쿼드로 K500M, 쿼드로 K510M, 쿼드로 K610M, 쿼드로 K1000M, 쿼드로 K2000M, 쿼드로 K1100M, 쿼드로 K2100M, 쿼드로 K3000M, 쿼드로 K3100M, 쿼드로 K4000M, 쿼드로 K5000M, 쿼드로 K4100M, 쿼드로 K5100M, 엔비디아 NVS 510 테슬라 K10, GRID K340, GRID K520 3.2 GK20A Tegra K1, Jetson TK1 3.5 GK110, GK208 지포스 GTX 타이탄 Z, 지포스 GTX 타이탄 Black, 지포스 GTX 타이탄, 지포스 GTX 780 Ti, 지포스 GTX 780, 지포스 GT 640 (GDDR5), 지포스 GT 630 v2, 지포스 GT 730, 지포스 GT 720, 지포스 GT 710,지포스 GT 740M (64비트, DDR3) 쿼드로 K6000, 쿼드로 K5200 테슬라 K40, 테슬라 K20x, 테슬라 K20 3.7 GK210 테슬라 K80 5.0 맥스웰 GM107, GM108 지포스 GTX 750 Ti, 지포스 GTX 750, 지포스 GTX 960M, 지포스 GTX 950M, 지포스 940M, 지포스 930M, 지포스 GTX 860M, 지포스 GTX 850M, 지포스 845M, 지포스 840M, 지포스 830M 쿼드로 K2200, 쿼드로 K1200, 쿼드로 K620, 쿼드로 M2000M, 쿼드로 M1000M, 쿼드로 M600M, 쿼드로 K620M, 엔비디아 NVS 810 5.2 GM200, GM204, GM206 지포스 GTX 타이탄 X, 지포스 GTX 980 Ti, 지포스 GTX 980, 지포스 GTX 970, 지포스 GTX 960, 지포스 GTX 950, 지포스 GTX 750 SE, 지포스 GTX 980M, 지포스 GTX 970M, 지포스 GTX 965M 쿼드로 M6000 24GB, 쿼드로 M6000, 쿼드로 M5000, 쿼드로 M4000, 쿼드로 M2000, 쿼드로 M5500, 쿼드로 M5000M, 쿼드로 M4000M, 쿼드로 M3000M 테슬라 M4, 테슬라 M40, 테슬라 M6, 테슬라 M60 5.3 GM20B Tegra X1, Jetson TX1, Jetson Nano 6.0 파스칼 GP100 쿼드로 GP100 테슬라 P100 6.1 GP102, GP104, GP106, GP107, GP108 엔비디아 타이탄 X, 지포스 GTX 1080, GTX 1070, GTX 1070 Ti, GTX 1060, GTX 1050 Ti, GTX 1050 쿼드로 P6000, 쿼드로 P5000, 쿼드로 P4000, 쿼드로 P2200, 쿼드로 P2000, 쿼드로 1000, 쿼드로 P620, 쿼드로 P600, 쿼드로 P400 테슬라 P40, 테슬라 P4 6.2 GP10B Jetson TX2 7.0 볼타 GV100 엔비디아 타이탄 V 쿼드로 GV100 테슬라 V100 7.2 GV10B Jetson AGX Xavier, Jetson Xavier NX 7.5 튜링 TU102, TU104, TU106, TU116, TU117 엔비디아 타이탄 RTX, 지포스 RTX 2080Ti, RTX 2080, RTX 2070, RTX 2060, 지포스 GTX 1660 Ti, GTX 1660, GTX 1650 쿼드로 RTX 8000, 쿼드로 RTX 6000, 쿼드로 RTX 5000, 쿼드로 RTX 4000 테슬라 T4 8.0 암페어 GA100 엔비디아 A100, 엔비디아 A30 8.6 GA102, GA104, GA106, GA107 지포스 RTX 3080, 지포스 RTX 3070, 지포스 RTX 3060Ti, 지포스 RTX 3060, 지포스 RTX 3050Ti, 지포스 RTX 3050 쿼드로 RTX A6000, 쿼드로 RTX A5000, 쿼드로 RTX A4000, 쿼드로 RTX A3000, 쿼드로 RTX A2000 엔비디아 A40, 엔비디아 A10, 엔비디아 A16 9.0 9.1 9.2 10.1 10.0

‘*’ – OEM 전용 제품

언어 결합 [ 편집 ]

예제 [ 편집 ]

이 예제는 텍스처 하나를 어떤 이미지로부터 GPU상의 행렬로 읽어들인다.

cudaArray * cu_array ; texture < float , 2 > tex ; // 행렬 할당 cudaMallocArray ( & cu_array , cudaCreateChannelDesc < float > (), width , height ); // 이미지 데이터를 행렬로 복사 cudaMemcpy ( cu_array , image , width * height , cudaMemcpyHostToDevice ); // 행렬을 텍스처에 연결한다. cudaBindTexture ( tex , cu_array ); // 커널을 실행한다 dim3 blockDim ( 16 , 16 , 1 ); dim3 gridDim ( width / blockDim . x , height / blockDim . y , 1 ); kernel <<< gridDim , blockDim , 0 >>> ( d_odata , width , height ); cudaUnbindTexture ( tex ); __global__ void kernel ( float * odata , int height , int width ) { unsigned int x = blockIdx . x * blockDim . x + threadIdx . x ; unsigned int y = blockIdx . y * blockDim . y + threadIdx . y ; float c = texfetch ( tex , x , y ); odata [ y * width + x ] = c ; }

파이썬 [ 편집 ]

파이선 언어의 바인딩은 PyCUDA에서 구할 수 있다.

아래 예제는 두 배열의 곱을 GPU 상에서 계산한다.

import pycuda.driver as drv import numpy import pycuda.autoinit mod = drv . SourceModule ( “”” __global__ void multiply_them(float *dest, float *a, float *b) { const int i = threadIdx.x; dest[i] = a[i] * b[i]; } “”” ) multiply_them = mod . get_function ( “multiply_them” ) a = numpy . random . randn ( 400 ) . astype ( numpy . float32 ) b = numpy . random . randn ( 400 ) . astype ( numpy . float32 ) dest = numpy . zeros_like ( a ) multiply_them ( drv . Out ( dest ), drv . In ( a ), drv . In ( b ), block = ( 400 , 1 , 1 )) print dest – a * b

행렬 곱셈을 단순화하는 추가 파이선 바인딩을 사용한 예제이다.

import numpy from pycublas import CUBLASMatrix A = CUBLASMatrix ( numpy . mat ([[ 1 , 2 , 3 ],[ 4 , 5 , 6 ]], numpy . float32 ) ) B = CUBLASMatrix ( numpy . mat ([[ 2 , 3 ],[ 4 , 5 ],[ 6 , 7 ]], numpy . float32 ) ) C = A * B print C . np_mat ()

같이 보기 [ 편집 ]

각주 및 참고 문헌 [ 편집 ]

제이슨 샌더스, 에드워드 캔드롯 저, 박춘언 역, 예제로 배우는 CUDA 프로그래밍(입문자를 위한 GPGPU 프로그래밍의 기초), ISBN 9788994774060. Farber, Rob 저, CUDA Application Design and Development, ISBN 9780123884268. Hwu, Wen-Mei 저, GPU Computing GEMs – Jade Edition, ISBN 9780123859631.

CUDA (쿠다) 란, 왜 사용하는 것인가.

CUDA (Computed Unified Device Architecture) 는 NVIDIA 사에서 개발한 GPU (Graphic Processing Unit)개발 툴이다. (설치방법 링크)

CUDA C 라는 언어를 사용하고 C++/C 등에 넣어 사용할 수 있다.

(이 블로그에서는 C++에 넣어 사용할 예정이다. IDE (Integrated Development Environment) 는 비쥬얼 스튜디오를 사용한다.)

CUDA의 역사와 원론적인 이야기는 NVIDIA 홈페이지나 여타 다른 블로그에 소개되어 있기 때문에 간단하게 설명하겠다.

2006년 NVIDIA는 Fermi Architecture 를 발표하며 CUDA 를 세상에 내놓았다. 이전까지는 전문가들이 아니면 GPU 를 이용한 프로그래밍이 어려웠는데 CUDA 의 등장 이후 많은 프로그래머들이 GPU 를 이용한 프로그래밍이 가능하게 되었다.

CUDA를 사용하는 이유는 매우 간단하다. 많은 양의 연산을 동시에 처리하자.

기존의 컴퓨터 연산은 CPU (Central Processing Unit)을 사용했다. (RAM (Random Access Memory)에 있는 데이터를 연산한다.)

CPU 를 이용한 연산은 대부분 Single-Core(사람의 뇌 라 생각하면 됨)를 사용하고 OpenMP (MultiProcessing) 등을 이용하여 Multi-Core 를 이용한 연산을 할 수 있다.

이에 반해 GPU 를 이용한 연산 Many-Core 를 이용하고 VRAM (Video RAM) 에 있는 데이터를 연산한다.

Core 당 속도는 당연히 CPU 가 GPU 보다 더 빠르다.

CPU 는 대부분 코어 당 속도가 3.0 GHz 정도이고 GPU는 16년 하반기에 등장한 Pascal Architecture 의 경우에는 1.8 GHz 로 많이 증가했으나 이전 Maxwell 2th Architecture 에는 0.9GHz 정도였다.

하지만 코어 숫자는 CPU 의 경우 가정에서 쓰이는 것 기준 대부분 4 코어, GPU는 1500 코어 이상이다.

실제로 사용할 때 재귀연산 (recursive, 자기 자신을 재 참조하는 연산) 을 사용하는 함수는 ‘직렬’ 연산을 해야한다.

하지만 그 경우가 아니라면 병렬 연산을 해주는 것이 훨씬 효과적이다.

<그림 1> 행렬 연산의 예

위 연산을 예시로 살펴보자.

먼저 직렬 연산이 더 빠른 재귀연산 (recursive) 의 경우에 대해 살펴보자.

이 연산을 할 때 1행1열에 더해질 숫자를 입력한 후 행/열 순으로 증가하며 이전에 더했던 숫자와 같은 수를 각 행에 더한다고 할 때 1행1열의 덧셈 이후 2행1열의 덧셈을 진행할 때 이전에 더해진 값을 알아야 하기 때문에 연산이 순차적으로 진행된다. 그렇기 때문에 이 글에서 소개하고자 하는 CUDA 의 ‘병렬’연산에는 적합하지 않고 단일 코어의 속도가 높은 CPU 를 이용한 연산이 더 유리하다.

(글이 길어져 이해가 안될수도 있고 설명이 부실하기 때문에 넘어가도 무관하다.)

4×4 행렬 모든 성분에 1씩 더해주는 연산을 한다. 직렬 연산의 경우 이 연산을 16번에 걸쳐 하지만 병렬 연산의 경우 16번의 연산을 한 번에 걸쳐 한다.

앞서 말한 CPU / GPU 의 코어 수, 속도로 살펴보자. 코어 당 속도가 CPU가 GPU의 2배일 때 CPU로 연산을 하면 8 의 시간이 걸리던 것이 GPU를 이용하면 1의 시간이 걸린다. (상대적인 속도)

위에 글이 이해가 안된다면 링크의 영상(NVIDIA 에서 제공하는 GPU 와 CPU의 비교, 1분 30초 가량)을 참고하면 된다. (사실 이 영상이 이 글의 전체 내용이다.) (유튜브 플러그인 적용 후 아래 영상 첨부)

<동영상 1> NVIDIA GPU vs CPU 유튜브 영상

(하지만 이 영상에서의 CPU 역할의 굵은 페인트볼처럼 CPU 는 조잡한 작업을 하진 않는다. 오히려 한 코어 당 더 많은 작업을 한다고 생각하는 게 맞다.)

<참고 문헌>

<그림>

<동영상>

1. NVIDIA CUDA 소개 영상 (https://youtu.be/-P28LKWTzrI)

CUDA (쿠다) 란, 왜 사용하는 것인가.

CUDA (Computed Unified Device Architecture)는 NVIDIA에서 개발한 GPU 개발 툴이다. 사실 CUDA는 c, c++기반으로 짜여진 완전 기초적 H/W 접근을 해야하는데, 많은 연구자들이 딥러닝에 사용할 수 있도록, 쉽게 설치할 수 있도록 오픈하였다. 현재는 nvidia-driver, CUDA, CUDNN만 설치하면 딥러닝을 쉽게 사용할 수 있다.

CUDA를 사용하는 이유는 매우 간단한데, 많은 양의 연산을 동시에 처리하는 것이 목표이다. 그러므로 딥러닝, 채굴과 같은 수학적 계산에 많이 쓰인다. 미분은 컴퓨터로 가능하기 때문이다.

기존의 컴퓨터 연산은 CPU를 사용하고, RAM에 의존하여 연산을 진행하였다. CPU를 이용한 연산은 대부분 Single-Core(Human-Brain)를 사용하고 MultiProcessing, Multi-Threading 등을 이용하여 CPU가 보유한 코어 갯수 만큼의 Multi-Core를 이용하여 연산을 할 수 있다. 일반적으로 딥러닝에서 사용하는, 특히 pytorch나 tensorflow 에서, data loader 파트에서, core 갯수를 주고 데이터 loading 하는 부분이 여기에 속한다.

이에 반해 GPU는 Core 갯수가 엄청나다. CPU는 8~16개인데 비해 GPU는 몇 천개 이상이다. 즉 이를 이용한 Many-Core dependent 연산을 진행하고, Video RAM에 있는 데이터를 연산한다.

각 각의 Core 별 속도는 CPU가 GPU보다 훨신 빠르다. CPU의 코어 당 속도가 3.0 GHz 정도이다. GPU 같은 경우, 16년 하반기에 등장한 Pascal Architecture 의 경우 1.8 GHz 로 많이 증가했으나 이전 Maxwell 2th Architecture에서의 속도는 0.9GHz 정도였다. 그렇지만 코어의 숫자는 이 때 당시의 CPU의 경우 집에서 게임하거나 사무용으로 쓰이는 평균의 개수는 4코어, GPU는 1500 코어 이상이었다.

많은 연구자들이 사용하는 python, matlab 같은 경우 행렬 연산을 사용할 수 밖에 없다. 이 때 쓰이는 것이 재귀연산 (recursive 연산)인데, 이 함수는 ‘직렬’ 연산을 해야한다. 하지만 이런 경우가 아니고 단순 계산, 예를 들어 backpropagation을 진행하며 보는 미적분 같은 경우 병렬 연산을 해주는 것이 훨씬 효과적이다.

행렬 연산

위의 경우 (4,4) 행렬이다. 연산이 더 빠른 직렬 연산의 경우에 대해 살펴보겠다. (1,1) 위치에 더해질 숫자 (1)를 입력 후 행/열 순으로 증가하며 previously adding 된 각 행에 더한다고 하면, (1,1) 위치의 덧셈 이후 (2,1)의 덧셈을 진행할 때 마찬가지로 이전에 더했던 값을 알아야 된다. 그러므로 연산이 순차적으로 진행되어야 한다. 이런 경우에는 병렬 연산에는 적합하지 않고, 단일 코어의 속도가 높은 CPU를 이용한 연산이 더 유리하다,

(4,4)행렬 모든 성분에 만약 1의 값을 더한다는 연산 process에 대해 논해보자. 직렬 연산의 경우 이 연산을 16번 (4,4 행렬이므로) 해야 끝나지만, 병렬 연산의 경우 16번의 연산을 병렬인 한 번에 처리한다. 즉 같은 값을 더해 주기 때문이다.

앞서 언급한 CPU와 GPU의 코어 수, 속도로 살펴보았을 때, 코어 당 속도가 CPU가 GPU의 2배라고 가정하자. 이럴 경우 CPU로 연산하면 8의 시간이 걸린다고 하였을 경우(0.5 x 16), GPU를 이용하면 1의 시간이 걸린다. (1 x 1)

아래의 영상을 보면, NVIDIA에서 제공해주는 CPU와 GPU의 비교 영상이다.

NVIDIA에서 공개한 GPU vs CPU

https://youtu.be/-P28LKWTzrI

So you have finished reading the 쿠다 topic article, if you find this article useful, please share it. Thank you very much. See more: 쿠다 프로그래밍, 쿠다 파이썬, CUDA wiki, 라데온 쿠다코어, cuda 지원 그래픽카드, 쿠다 설치, 지포스 쿠다, 쿠다코어 갯수